|

seo优化的技术好坏不仅仅在于内容和外链上,更重要的是一些细节上的处理,因为内容和外链相对来说需要掌握的要点不是很多,而且易于操作、容易理解;而网站优化的其他一些细节处理,相对来说平时接触的少,对于这些了解的也很少,真正要处理时却遇到很多问题,比如seo优化常规的404页面的制作,301重定向的处理,robots的一个创建等,对于网站来说都是不可或缺的一部分。 下面来说说robots,首先它是一个协议,对于网站的抓取取到重要作用,创建robots的意义在于它可以让蜘蛛听从命令服从安排,解决了网站的一些隐私和不必要抓取的页面,同时也可以强调某一部分必须抓取。robots看似一个非常简单的操作,但平时如果没有太注意或多操作,你写的robots未必就是正确的,因为里面涉及到一些指令,没有写对可能会影响网站的抓取。 百度站长平台推出了robots工具(),只要注册下,认证下网站就ok了,它可以很好的检验你的robots写的是否正确,该工具可以检测您的网站是否有robots.txt文件,及robots.txt文件内容,并能按照您的需求生成正确的robots.txt文件,为robots文件的制作起到了很大的帮助。 一、可以检测到网站是否有robots文件 通过网站验证后,你可以任意测试网站,看该是否有制作robots,如果有它会一一列出你网站设置的情况,比如什么文件有抓取,什么文件被屏蔽了,一目了然,并且提示是否有错误的地方;而没做robots协议的,他也会提示:“您的网站没有robots.txt文件,表示您允许搜索引擎可以抓取您网站全部的内容”。如图所示(chinaz的robots检测结果):

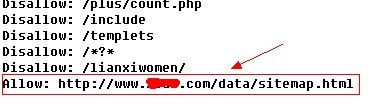

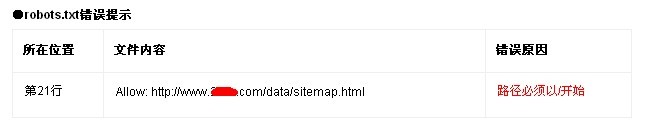

二、可以检测到网站robots是否正确 很多朋友都是想当然,认为robots书写很简单,真正测试一下就会发现是错误的。在robots添加网站地图相信是大家都很熟悉的,主要目的是让搜索引擎蜘蛛顺利抓取网站地图,屏蔽蜘蛛是用Disallow,允许抓取时用Allow,想当然很多站长为了让蜘蛛抓取网站,直接把网站地图定义为:Allow: ***.com/sitemap.html,结果检测一下原来是错误的,如图:

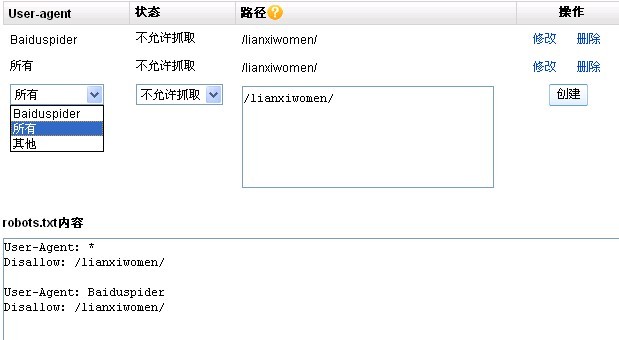

百度一下才发现,原来格式为Sitemap: ***.com/sitemap.html,虽然这个操作很简单,但如果没有robots工具的辅助,你可能长时间也不会发现这个问题。 三、按你的需求生成正确的robots.txt文件 如果你不懂如何制作robots文件,里面有很详细的内容介绍,包括robots的概念、如何制作等,利用表格的形式一一列出来,并且还有多方面的例子,比起百度百科要清晰明了的多,了解了概念后,当然就是手动制作了,它能够很好的按照你的想法一一生成内容,比如你不想让制作抓取联系我们这个页面,你就可以直接在上面操作:

完成后只需要将文件下载下来,放到网站的根目录就大功告成了,感觉是不是比看百度百科要清晰明了的多了?另外很多操作的细节利用百度是没办法解决的,毕竟网站上的内容或者观点很多都是有误的,只能好好利用百度官方的工具才是最好的!文章由淘宝网登陆 小编原创,转载请加上文章中链接,谢谢合作。 (责任编辑:admin) |