|

一、服务器响应代码 有几个服务器响应代码,会影响你进行搜索引擎优化,例如301、302和404。这些数字是指运行服务器指令,当用户试图请求一个页面。这些反应可能是301、302、或404这意味着请求的页面不存在。一个301响应代码意味着请求的页面已被永久地搬到一个新的位置,即跳转。同样,302是一个临时的重定向或页面级别重定向的资源被移 动,但它已经不是在服务器级配置 。

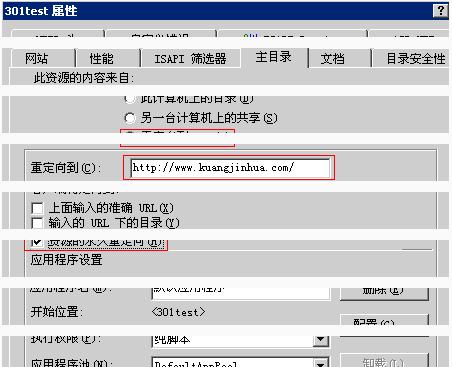

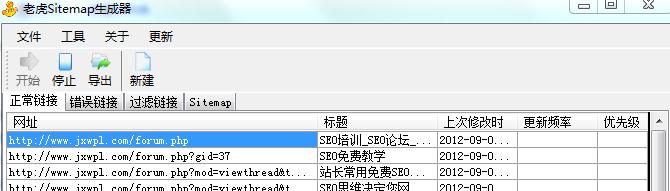

在检测网站时,关键是要寻找301和302作为搜索引擎将指向最终目的地URL,因此重要的是要确保301、302代码是搜索引擎友好和能从一个页面到另一个进行跳转。我们可以使用一些工具来检查。404错误页面处理肯定需要检测的。错误链接会导致蜘蛛无法爬行,如果在你的站点上不能爬那么他们肯定不能在搜索引擎索引。因此不能收录,网站没有快照更新。通过站长工具和谷歌管理员工具可以查询错误链接 二、动态或不友好的url 含有“?”的URL可算动态URL,静态页面后缀一般为.html .htm .shtml。如 是静态url?mod=post&action=newthread&fid=56是动态url 开了伪静态之后关闭动态,百度更信任伪静态,所以伪静态不能改为动态。静态URL在搜索引擎上有一定的好处。可以更加方便搜索引擎蜘蛛来抓取网页。方便用户浏览。 三、重复内容的问题 最常见的问题和重复内容是内部竞争。当一个搜索引擎可以访问和索引的多个版本相同的页面,有很大可能会过滤掉所有的索引。 最常见的例子是在电子商务站点复制内容,制造商的产品描述被几乎所有的零售商复制。最简单的方法来确定你有重复的内容是检查CopyScape上。 为了避免这种情况,在产品描述添加一些自己的评论,让它变得独一无二,你可能在竞争者中脱颖而出——他们很可能使用相同的制造商提供的产品描述。重复页面不仅浪费蜘蛛,而且浪费页面,最好使用301重定向作为一个更持久的长期解决方案。 四、XML网站地图问题 网站xml地图包含所有链接,有清晰的框架,便于蜘蛛爬行,提高收录,尤其是没有伪静态的网站。XML地图直接提交到搜索引擎可以帮助蜘蛛发现新的内容。所有的搜索引擎提供一种方式让网站所有者提交XML网站地图,因此有必要利用这个特性。这应该是一个关键的部分技术检测。

我们可以使用老虎Sitemap生成器生成XML地图,然后保存为txt文件上传。 (责任编辑:admin) |