|

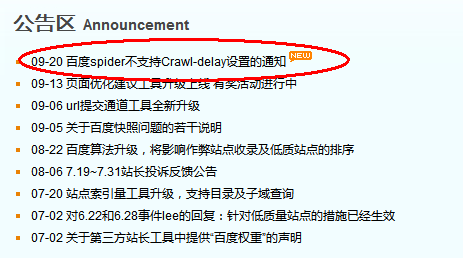

今天中午百度站长社区平台更新了一条公告,如下:

尊敬的各位用户,亲爱的站长们,大家好: 近期,我们收到一些对Crawl-delay用法的询问,现明确百度对网站访问频率不再参考该设置,即不支持Crawl-delay配置,如果您希望配置网站针对百度spider的访问频率,建议您使用百度站长平台的抓取压力反馈工具,先查询网站在百度近一个月的天级抓取量趋势图,可调节百度spider每天访问您网站的抓取压力上限,供百度参考,避免百度spider对站点抓取压力过大,造成网站服务器负载及抓取异常。 相信很多人都不清楚什么是Crawl-delay,笔者也是才知道有这个东西,通过搜索,笔者了解到Crawl-delay翻译成中文意思是抓取延迟的意思。那么Crawl-delay到底干什么用的呢?用在什么地方呢?笔者在一番查询之后整理出来,与大家分享: 要谈到Crawl-delay的用途,还需要提及大家都比较熟悉的Robots协议,网站通过robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。而通过Crawl-delay我们可以设置一个让蜘蛛有较低的抓取请求频率,这样就可以降低了服务器的压力,而设置Cralw-delay的大小应该根据服务器能够承受的压力和机器人的数量来确定。例如你希望yahoo的机器人每2秒来一次,就应该先查看访问服务器的yahoo的机 器人有多少个,假如有40个yahoo机器人,这个参数就应该设置为2*40=80。但如果40多个爬虫恰好都在同一个时间段内采集,即便每只间隔100秒,40只先后脚的来爬,到最后一只 爬完后,第一只的间隔时间又到了,造成的压力很大了,不过这可能是最“理想”状态下才会发生的。 接下来展示一个 Crawl-delay的应用实例:

大家可以看到Crawl-delay 后面的数值100表示告诉蜘蛛程序,以秒为单位的最低延时。如果crawler频率对您的服务器是一个负担,您可以将这个延时设定为任何您认为恰当的数字,每间隔100s来爬行一次。这个设置似乎只针对于大站,小站很少见,设置Crawl-delay注要原因是蜘蛛程序爬的过快,会给服务器照成负担,影响正常的网站展示速度。 百度此次特地发出声明说不支持Crawl-delay设置,并不代表从此Crawl-delay设置无用武之地。目前支持这个参数的搜索引擎有Slurp(yahoo和altaVista的机器人)、MSN使用的微软机器人,Googlebot还没有使用“Crawl-delay”参数,现在百度也没有,那么我们可以反过来想,如果我们主要是以百度搜索为主要推广手段以其他搜索引擎为辅助的话,我们可以在服务器条件不好的情况下,通过设置Crawl-delay降低其他搜索引擎的抓取频率,这样就可以合理的减少服务器压力,从影响优化因素的角度来讲也是一个好消息! 所以,不管百度怎么变,宗旨是不会变的,我们在围绕百度做优化的同时,合理的采取一些小技巧,也许会收到意想不到的收获! 文章编辑由南昌胃肠检查独家编撰,转载请勿删除源地址! (责任编辑:admin) |