|

当我第一次开始seo工作的时候,我是作为一个没有毕业的实习生进入一家seo企业公司,我是作为一个web开发人员进入这家公司,当然对我来说完全编写代码,我的经验非常有限,我需要花更多的时间和努力来扩充我的知识。 更加具体点说,我的工作是配合seo技术实现商业实践,这对我来说更是一个挑战,对于seo技术我没有任何概念,所以我更需要花几周的时间对seo的一些基础理论知识继续拧拉结,在我每学一个知识和概念的时候我都都会做一个备忘录,里面好汉了定义,包含了一些代码片段,今天看到之前自己所做的一些小抄,觉得很有意思就和大家分享其中一部分内容。 1、seo的html标记

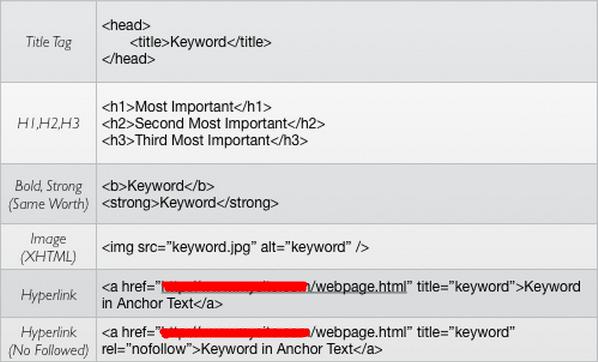

这个部分包括了所有重要的seo的html标记,除了清单标记之外,还提供了代码示例。 2、搜索引擎索引限制

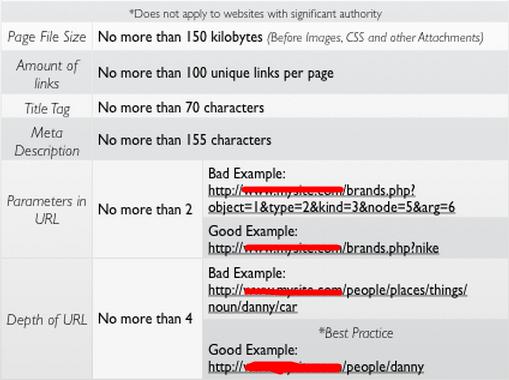

这个部分包括搜索引擎强加在网站上的一些索引限制,有关键词秘洞,网页链接数量,为了便于在变成的时候使用,所有在记录的时候一般都选择了编程中会使用的一些词语。 3、推荐标题标签的语法

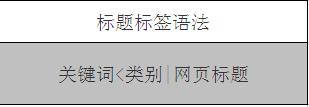

这里包含了推荐的标题标签的语法,尽管许多伟大的格式已经在seo设计中被形成,但在笔者开始学习seo的时候,接触的还是以上的这种格式。 4、共同规范的问题

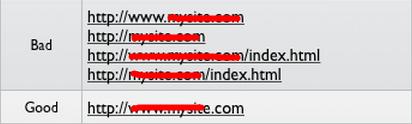

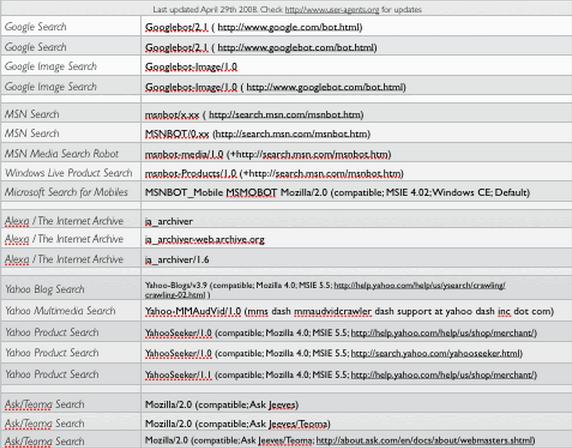

其实这里记载的是比较一些常见的常规问题,并且针对这些问题提供的一个解决方案,所有的常见问题的格式都是这样的,而这里说的是对首页默认的url设计。 5、重要的搜索引擎机器人用户代理

这个部分包括一个列表的所有蜘蛛用户代理的重要的搜索引擎,当然这个名单上的版本可能现在已经过时,但他们的古怪的名字还是有用的,可以通过他们找到现在的最新版本。 6、robots.txt语法

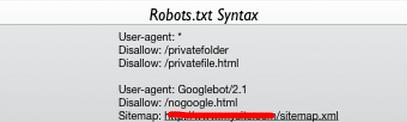

一个简单的robots.txt文件就可以阻止特定的机器人对站点抓取,整个目录和特定的文件。 7、站点地图语法

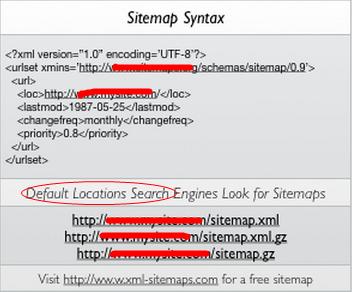

本部分内容展示了标准化的站点地图.xml,还理出了默认搜索引擎寻找站点地图的地方。 By:转载请保留有效的链接地址,Thanks! (责任编辑:admin) |