|

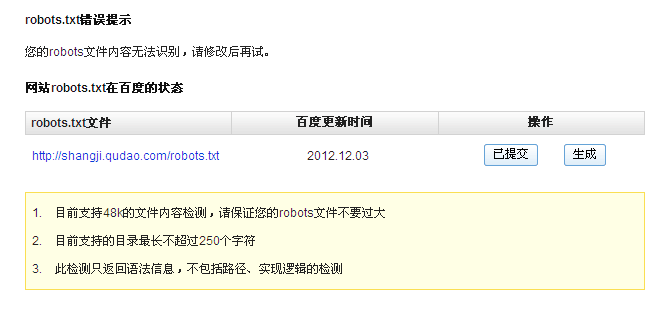

今天无意中看到一位站长朋友的诉说,讲的是他新站为什么没有被收录,从发现问题的原因到解决问题中一系列的工作。感觉比较典型,很多人可能会遇到,现在贴出来分享给大家。 问题原因: 该站长在新站上线后不久,网站内部就出现了重大的bug(漏洞)。该站长先用robots.txt文件屏蔽了搜索引擎的的抓取,然后对网站的bng进行修复。 问题处理: 等到网站的bug修复完成后,该网友再次对robots.txt文件进行了修改,允许所有搜索引擎的抓取。表面上看做到这一步就可以等搜索引擎过来抓取内容了,可是一个星期过去网站一点反应也没有,查看网站日志,连蜘蛛都木有来过。于是干脆删除了网站的robots.txt文件。 问题原理: 通过百度站长工具检测,发现了原来原因就隐藏在robots.txt文件中,当他发现网站有bng的时候,他禁止了搜索引擎的抓取,而蜘蛛发现这个网站是禁止抓取的,就会默认一个时间段不在去爬了。百度的站长工具显示,网站robots.txt文件更新时间就停留在禁止搜索引擎抓取的那天,以后都没在更新过。这也就更加证明了蜘蛛在爬行到一个禁止抓取的页面,它就不在抓取,并默认下次在来抓取的时间间隔,这就可以解释了很多站长为什么在解除robots.txt文件限制蜘蛛抓取后,也要一段才会重新收录新内容的原因了,只是以前百度没有出站长工具我们不知道而已。 解决办法: 知道了原理,那么解决起来也就容易多了。大家请看下图:

先去开通百度站长工具-robots.txt工具,在更新一下就可以了,新站没有收录一定不要忽略robots.txt文件。 本文版权:SEO学堂 转载请注明! (责任编辑:admin) |