|

分析网站日志也是日常seo工作的一部分,我们可以通过日志上显示的各种代码来观察搜索引擎蜘蛛今天对网站的访问和抓取情况,找出不足和原因,进而改善网站的优化方案。但是很多站长自认为自己的网站做得十分完美,但是日志却显示蜘蛛访问频率很少,这无疑是给努力的站长们拨了一盘冷水。 为什么蜘蛛表示对你的网站访问压力巨大?事出必有因,蜘蛛只是一个机器人,它遵循程序的设定,如果它不愿意访问你的网站,那只能说明你的网站肯定存在各种各样的阻碍爬行的因素。下面笔者就自身的经验来和大家分享一下,哪些问题会让蜘蛛访问压力变大吧。

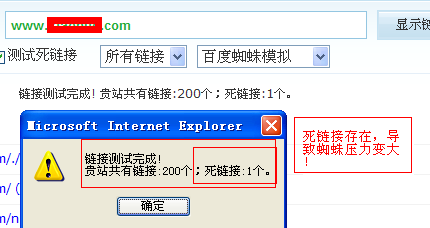

第一:网站存在大量的死链接 所谓的死链接就是就是返回代码为404的错误页面链接,这类链接通常产生于网站改版后、或者网站更换域名后。这类死链接无论是对用户还是对百度蜘蛛来说,都是一种非常不友好的表现。试想一下,当蜘蛛兴高采烈来到你的网站访问,却接二连三地碰到那些挡道的死链接,重复的情况不断出现,最后让蜘蛛不再信任你的网站,继而也产生网站不被收录的结果。 解决办法:(1)提交死链接。利用百度站长平台的“死链提交”工具来提交网站死链,具体说明请参考百度站长工具。 (2)对死链进行301重定向。这个办法是针对死链接较少的网站的,如果你的网站死链接只有一两条,那么可以把死链接页面重定向到首页或者其他页面,但是这也可能导致用户体验不那么友好。

第二:网站地图出现错误 以往很多seo的技术教程都告诉我们,制作网站地图十分重要。但是现在很多站长都会忽略网站地图这一块工作,由于对代码的不熟悉,因此很多站长会使用一些不靠谱的工具随便制作一张网站地图。笔者认为,与其随便制作地图,还不如不制作。试想想,你给一张错误的地图蜘蛛走,当蜘蛛迷路了,它会不会恨你?所以,笔者建议,如果网站地图能亲手制作就亲手制作,如果不能可以选择一些比较权威的工具,如百度的站长工具和chianz的站长工具等等。做好后还要测试一下,看哪里存在问题,并且通过日志观察,蜘蛛是否能够在地图上顺畅地爬行。 第三:网站存在蜘蛛陷阱 所谓的蜘蛛陷阱就是网站存在某些问题,让蜘蛛在爬行网站时候发生错误,陷入网站之中,继而无法走出网站。这种情况其实我们很难去发现,因为我们无法确定蜘蛛是否真的被困在蜘蛛陷阱之中,但是当我们发现蜘蛛爬行网站频率变小后,就应该开始意识到并检测自己网站是否真的存在蜘蛛陷阱了。笔者认为,造成蜘蛛陷阱大多数还是两个原因: (1)网站url参数过多。尽管百度告诉我们,现在百度蜘蛛已经能够抓取非静态url,但是包含参数过度的非静态url对于百度蜘蛛来说还是很有压力的,如下图:

这种复杂的非静态url会让百度蜘蛛感到头晕脑胀,最后就可能造成蜘蛛无法走出这个页面而引致所谓的蜘蛛陷阱了。 (2)网站锚文本过多,造成内链链轮。外部链轮相信大家都会认识,但是其实内部链接也是可以产生链轮的。很多站长为了提升关键词排名,不惜使用过多的锚文本,然后造成页面之间的链接轮回效应,最后也让蜘蛛走进了无底洞,无法走出来了。 搜索引擎蜘蛛虽然只是一个机器人,不能与人类的智商比较,但是我们作为站长还是应该尊重蜘蛛,遵循它的规定,不应该让网站存在过多的问题而导致它压力变大。只有我们的网站能够改善以上的问题,相信直至会越来越其青睐我们的网站的。本文专为北京积水潭医院网上挂号供稿,希望转载的朋友加上一条链接,谢谢大家支持! (责任编辑:admin) |