|

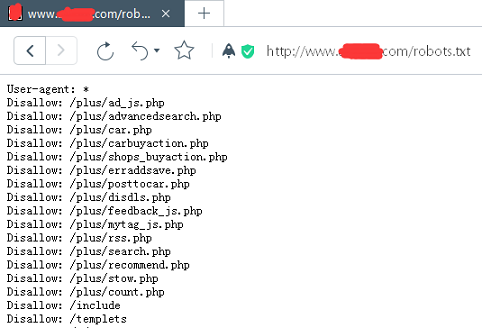

网站程序勤打补丁:现在很多资讯类网站用的系统使用了内容管理系统(CMS),作为新闻发布系统,功能还算可以了,但是作为比较常见的内容管理系统(CMS),也有另一个问题,那就是漏洞比较大众化,因为源码是公开的,所以很容易被研究出漏洞,需要对网站程序及时进行漏洞修复。 √ 对服务器进行常规的安全防护 在上班时间之外,对服务器上的网站权限做设置,禁止文件修改,后台文件隐藏或迁移到根目录之外 参考一些网站的安全设置,非限定的IP不能写入到数据库。 √ 不使用开源程序默认的robots文件 下图是一个地级市的资讯类站点的robots文件,从robots文件中可以看出,该网站用的是织梦后台,那黑客就可以通过各种针对织梦攻击的软件进行操作了,也可以针对织梦网站的常见漏洞进行扫描和针对性攻击了。

2.4.4 网络服务 2.4.4.1 CDN 从搜索抓取机制上讲:百度蜘蛛对站点的抓取方式和普通用户访问一样,只要普通用户能访问到的内容,百度蜘蛛就能抓取到。不管是用什么技术,只要能保证用户能流畅的访问网站,对搜索引擎就没有影响。但有站长反馈使用CDN后出现网站抓取异常、甚至流量异常等问题,主要是两方面的因素: 一是部分CDN服务商硬件投入不够,经常出现不稳定情况,会导致大量的蜘蛛抓取失败,从而影响网站抓取效果,有的甚至影响了索引量数据;所以选择有实力的CDN服务商很重要; 二是缓存机制在网站出现死链、无法打开、被黑等情况的时候起到了推波助澜的作用。短时间内产生了一些不利快照,影响了排名。这种情况不用担心,及时清理源文件和CDN缓存,并在百度搜索资源平台(原站长平台)提交相关死链数据等方法进行挽回,是可以恢复的。 (责任编辑:admin) |